DeepSeek R1本地部署指南

DeepSeek团队最新发布的 DeepSeek-R1 模型在 GitHub 上迅速获得了超过4000个星标,引起了广泛关注。

这款模型不仅性能卓越,而且开源且支持商业使用,为AI开发者提供了新的选择。本文将详细介绍如何在本地环境中部署DeepSeek-R1模型。

一、准备工作

使用 Ollama 进行本地部署。

Ollama是一个轻量级的工具,可以帮助你在本地快速部署和运行大语言模型。

要安装Ollama,前往Ollama官网 https://www.ollama.com/ 下载适用于你操作系统的安装程序,并按照提示完成安装。

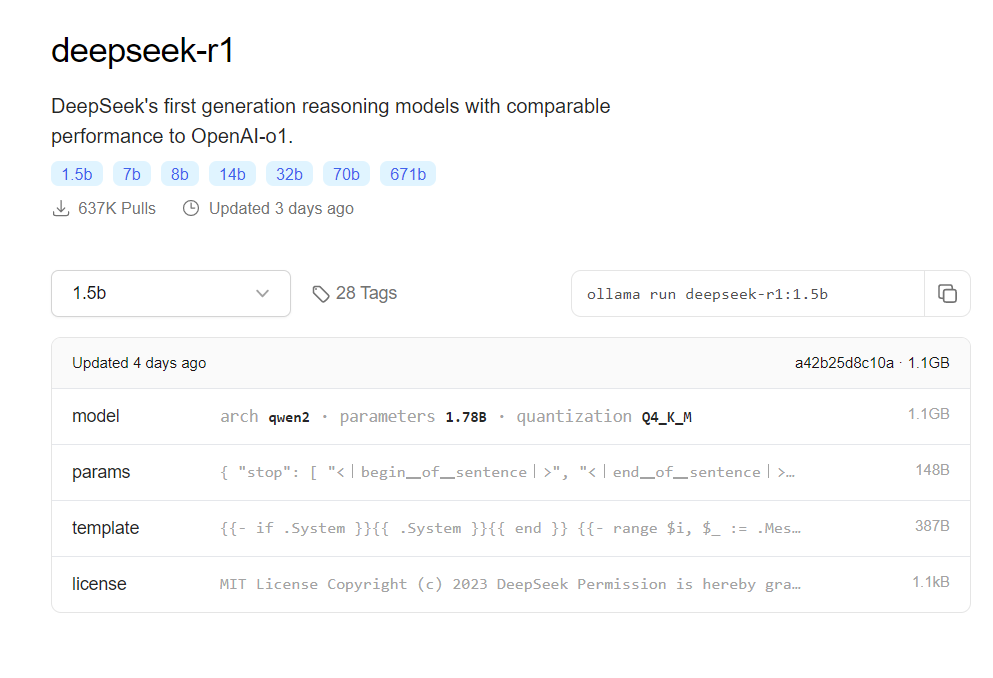

当前最轻量级的是1.5b,只要 1.1G 的空间就可以安装,不同量级所需要的空间不同,可以根据自己机器配置下拉选择:

二、正式安装

使用 Ollama 作为本地运行 DeepSeek-R1 的主干。

首先使用终端(macOS/Linux)安装 Ollama:

1 | curl -fsSL https://ollama.com/install.sh | sh |

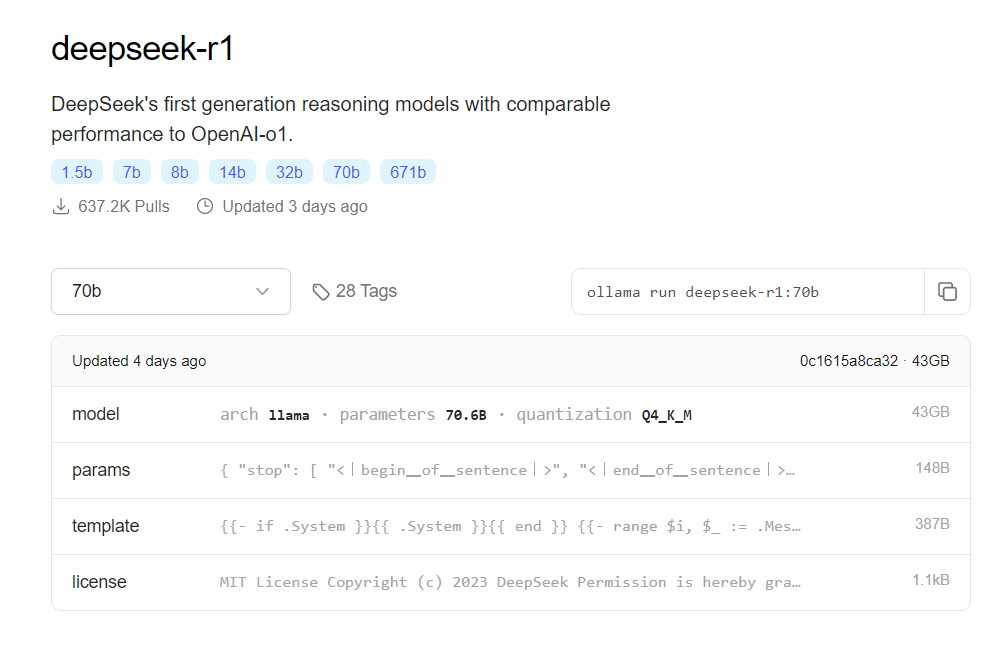

然后通过 Ollama 下载 DeepSeek-R1。选择适合你机器的提炼模型。deepseek-r1:671b 具有完整的 R1 功能,但是对服务器的要求自然也高。

1 | # Default 7B model (4.7GB - ideal for consumer GPUs) |

设置 Open Web UI(私有接口)。确保你的机器上安装了 docker,然后通过在终端上运行来安装 Open Web UI:

1 | docker run -d -p 3000:8080 \ |

访问 http://localhost:3000 并选择

deepseek-r1:latest。所有数据都保留在你的机器上,没有云跟踪或数据泄露。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 HuParry!

评论